Javaアプリケーションを本番環境で公開する際、そのままインターネットに接続していませんか。実は、その構成にはセキュリティや性能面で大きなリスクが潜んでいます。

私は過去10年以上、バックエンドエンジニアとして趣味でWebシステムの構築をしてきました。その時、システムを守る盾として導入したのが「Nginx」でした。

この記事を読めば、JavaとNginxを連携させる理由から、具体的な設定手順、トラブルシューティングまでを網羅的に理解できます。インフラ構築に自信がない方でも、安定したWebサーバー環境を構築できるようになるでしょう。

javaとnginxを連携させる目的と全体像

JavaとNginxを組み合わせる最大の目的は、それぞれの得意分野を活かしてシステムの安定性と性能を高める点にあります。

Javaは複雑なビジネスロジックの処理が得意ですが、大量の通信を同時にさばくのは苦手です。一方でNginxは、軽量で大量の同時接続を処理することに特化しています。この二つを連携させるのは、システム構築における定石といえます。

nginxが果たす役割(リバースプロキシ・ロードバランサ)

Nginxは、ユーザーからのアクセスを最初に受け取る「受付係」の役割を果たします。

これを「リバースプロキシ」と呼びます。ユーザーが直接Javaアプリにアクセスするのではなく、Nginxが一度リクエストを受け取り、それを後ろにいるJavaアプリに渡す仕組みです。また、アクセスが増えた場合に複数のJavaアプリへ処理を振り分ける「ロードバランサ」としての役割も担います。

この仕組みにより、Javaアプリは重い通信処理から解放され、ロジックの実行のみに集中できるのです。

javaアプリ(Spring Bootなど)とnginxの連携構図

基本的な連携の構図は、Nginxが前段(フロント)に立ち、Javaアプリが後段(バックエンド)に控える形になります。

具体的には、Nginxが80番ポート(HTTP)や443番ポート(HTTPS)で待機します。Javaアプリ(例えばTomcatやJettyを内蔵したSpringBoot)は、外部からアクセスできない8080番ポートなどで起動しておきます。

Nginxは受け取ったリクエストを、内部ネットワークを通じてJavaアプリのポートへ転送します。ユーザーからはNginxだけが見えており、裏側でJavaが動いていることは分かりません。この隠蔽がセキュリティ向上につながります。

nginx連携がJavaシステムにもたらすメリット

この連携構成を採用するメリットは、主にセキュリティ、パフォーマンス、柔軟性の3点です。

まずセキュリティ面では、Javaアプリを直接インターネットに晒さないため、攻撃を受けるリスクが減ります。次にパフォーマンス面では、画像やCSSなどの静的ファイルをNginxが高速に配信することで、Java側の負荷を大幅に下げられます。

さらに、SSL/TLS暗号化処理をNginxに任せることで、Javaアプリの設定をシンプルに保てるのも大きな利点です。証明書の更新作業もNginx側だけで完結するため、運用が非常に楽になります。

javaアプリをnginxと連携させるための基本設定

連携を実現するための設定は、決して難しくありません。基本的にはNginxの設定ファイルに数行追記するだけで完了します。

ここでは、Linux環境(UbuntuやCentOSなど)を想定して、インストールから設定ファイルの記述までを順を追って解説します。

nginxのインストールと基本設定

まずはサーバーにNginxをインストールしましょう。パッケージ管理ツールを使えばすぐに導入できます。

Ubuntuであればapt install nginx、CentOSであればyum install nginxを実行します。インストールが完了したら、サービスを起動して自動起動設定も有効にしておきましょう。これでサーバー再起動時にも自動的にNginxが立ち上がります。

設定ファイルは通常 /etc/nginx/nginx.conf または /etc/nginx/conf.d/ 配下にあります。これらを編集して連携設定を行います。

Javaアプリのポート公開(Tomcat/Spring Bootの設定)

Javaアプリ側は、ローカルからのアクセスだけを受け付けるように設定するのが理想です。

SpringBootを使用している場合、application.propertiesファイルでポートを指定します。通常はデフォルトの8080番ポートで問題ありませんが、複数のアプリを動かす場合はポートが被らないように8081、8082とずらす必要があります。

重要なのは、Javaアプリ自体を「0.0.0.0(全公開)」ではなく「127.0.0.1(ローカルホストのみ)」でリッスンさせる構成も検討することです。これにより、Nginxを経由しない直接アクセスを物理的に遮断できます。

nginx→javaアプリへのプロキシ設定の書き方(proxy_pass)

NginxからJavaへリクエストを送るには、proxy_passというディレクティブを使用します。

設定ファイルの location ブロック内に、転送先のURLを記述します。例えば、ローカルの8080番ポートで動いているJavaアプリに転送する場合は、以下のように記述します。

location / {

proxy_pass http://127.0.0.1:8080;

}この一行があるだけで、Nginxに来たアクセスは全てJavaアプリへと流れます。これが連携の最も基本的な形です。

javaとnginx連携でよく使われる構成パターン

システムの規模や要件によって、連携のパターンはいくつか存在します。ここでは代表的な3つの構成を紹介します。

ご自身のプロジェクトに最適な構成を選ぶための参考にしてください。

nginxをフロントにしたリバースプロキシ構成

最もシンプルで一般的なのが、1台のサーバー内にNginxとJavaアプリを同居させる構成です。

小規模なWebサービスや社内ツールであれば、この構成で十分です。Nginxが静的ファイルの配信とSSL終端を行い、動的な処理だけをJavaに投げます。サーバーのリソースを効率よく使えるため、コストパフォーマンスに優れています。

まずはこの構成から始めて、アクセスが増えてきたらサーバーを分けるステップアップが可能です。

複数Javaアプリをnginxでロードバランシング

Nginxの upstream ブロックを使用することで、複数の転送先をグループ化できます。例えば、Javaアプリを3つ起動しておき、Nginxが順番にリクエストを振り分ける設定が可能です。

これにより、1つのJavaアプリがダウンしても、他のアプリが処理を継続できるため、サービスの可用性が飛躍的に向上します。

静的ファイルはnginx、動的処理はjavaのハイブリッド構成

Webページの表示速度を極限まで高めたい場合、静的コンテンツと動的コンテンツの処理を明確に分離します。

画像、CSS、JavaScriptファイルは、Javaを経由させずにNginxから直接返却します。Nginxはファイルの配信が非常に高速だからです。Javaアプリにはデータベースアクセスが必要な処理だけを依頼します。

設定例としては、拡張子が .jpg や .css のリクエストはローカルのディレクトリを参照させ、それ以外を proxy_pass でJavaに送るように記述します。

java×nginx連携の実装例(Spring Boot例付き)

ここでは、具体的なコードや設定値を交えて実装例を解説します。実際に手を動かしながら確認してみてください。

Javaフレームワークとして人気の高いSpringBootを例に挙げますが、他のフレームワークでも基本的な考え方は同じです。

application.propertiesでポートを固定する

SpringBootアプリの起動ポートを明示的に指定します。

server.port=8080もしサーバー内で複数のJavaアプリを動かすなら、2つ目のアプリは8081にするなどして重複を避けます。開発環境と本番環境でポートを変えたい場合は、プロファイル機能を使って設定ファイルを分けると管理しやすくなります。

nginxのserverブロック設定例(/apiをJavaに転送)

Webサイトの画面(HTML/JS)とAPIサーバーを分ける構成の例です。/api で始まるURLだけをJavaに転送する設定です。

server {

listen 80;

server_name example.com;

# 静的ファイル(ReactやVueのビルドファイルなど)

location / {

root /var/www/html;

index index.html;

try_files $uri $uri/ /index.html;

}

# APIリクエストはJavaへ転送

location /api {

proxy_pass http://127.0.0.1:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}このようにパスごとに処理を分けることで、フロントエンドとバックエンドをきれいに分離できます。

nginxでCORS・ヘッダー制御を行う場合のポイント

最近のWeb開発では、CORS(Cross-Origin Resource Sharing)の設定が必須となるケースが多いです。

Java側でCORS設定を行うことも可能ですが、Nginx側で一括管理したほうがコードの変更が不要になり、運用が楽になります。add_header ディレクティブを使って、許可するドメインやメソッドを指定します。

また、proxy_set_header を使って、クライアントの本来のIPアドレスをJava側に伝える設定も忘れてはいけません。これがないと、Java側では全てのアクセスがNginx(ローカルホスト)から来ているように見えてしまい、ログ分析ができなくなります。

javaとnginxを組み合わせる際の注意点

非常に強力な連携ですが、いくつか落とし穴があります。これらを知らずに運用を始めると、思わぬトラブルに見舞われる可能性があります。

特にタイムアウト設定やファイルサイズの制限は、初期設定のままだとエラーの原因になりやすいため注意が必要です。

タイムアウト設定(proxy_read_timeoutなど)

Java側で重い処理(例えば帳票作成やバッチ処理)を行う場合、レスポンスが返ってくるまでに時間がかかることがあります。

Nginxのデフォルトのタイムアウト時間は通常60秒です。もしJavaの処理が60秒を超えると、Nginxは「待ちきれない」と判断して接続を切断し、ユーザーにエラー画面を表示してしまいます。

これを防ぐには、proxy_read_timeout の値を長めに設定します。処理内容に応じて、300秒(5分)などに延ばす検討をしてください。

大容量リクエスト(ファイルアップロード)時のnginx側の制限

画像のアップロード機能などで、大きなファイルを送信しようとするとエラーになることがあります。

これはNginxの client_max_body_size という設定が、デフォルトで1MBに制限されているためです。スマホで撮影した写真などは数MBになることが多いため、この制限に引っかかります。

必要に応じて client_max_body_size 10M; のように記述し、上限を引き上げておく必要があります。Java側だけでなく、Nginx側の制限も確認するのがポイントです。

SSLはnginxで終端する?Java側で受ける?判断基準

通信の暗号化(SSL化)をどこで行うかという問題です。

基本的には「NginxでSSLを終端(復号)し、NginxとJavaの間は平文(HTTP)で通信する」構成をおすすめします。これにより、Javaアプリは暗号化の負荷から解放されます。

ただし、金融系システムなど極めて高いセキュリティ要件がある場合、内部ネットワークであっても暗号化が求められることがあります。その場合はJava側でもSSL設定を行いますが、運用コストとCPU負荷は高くなります。

javaとnginx連携で発生しがちなトラブルと解決策

設定をしたはずなのに動かない、という事態はよく起こります。エラー画面を見て焦らないよう、代表的なトラブルとその対処法を知っておきましょう。

ログファイルをしっかり確認することが、解決への近道です。

502 Bad Gatewayの原因と解決方法

「502 Bad Gateway」は、Nginx連携で最も頻繁に見かけるエラーです。

これは「Nginxは動いているが、転送先のJavaアプリと通信できない」ことを意味します。主な原因は、Javaアプリが起動していないか、起動ポートの設定が間違っていることです。

まずはJavaアプリが正常に起動しているか確認しましょう。次に、Nginxの設定ファイルに書いたポート番号と、Javaアプリが使っているポート番号が一致しているかを見直します。単純な数字のミスが原因であることが多いです。

プロキシ設定のミスで発生するパス不一致問題

Nginxの設定で末尾にスラッシュ / を付けるかどうかで、転送されるパスが変わる挙動があります。

例えば proxy_pass http://localhost:8080/app; と書くのと、proxy_pass http://localhost:8080/app/; と書くのでは、Java側に渡されるURLが異なります。これが原因で「404 Not Found」になることがあります。

基本的には、転送元のパスと転送先のパス構造を意識して、スラッシュの有無を統一することが大切です。

ロードバランス時のセッション切れ対策(Sticky Sessionなど)

複数のJavaアプリでロードバランシングを行う際、セッション情報が引き継がれない問題が発生します。

ユーザーがログインした情報をサーバーAが持っている状態で、次のリクエストがサーバーBに飛ぶと、サーバーBはログイン情報を知らないため「ログインしてください」と返してしまいます。

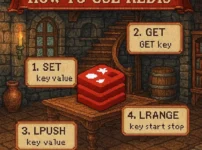

これを防ぐには、同じユーザーからのアクセスを常に同じサーバーに飛ばす「Sticky Session(ip_hash)」の設定をNginxに入れるか、Redisなどの外部ストアでセッション情報を共有する仕組みを導入します。

java×nginxの連携を最適化するためのチューニング

基本設定で動くようになったら、次はパフォーマンスを最大限に引き出すチューニングを行いましょう。

少しの設定変更で、処理能力が数倍になることも珍しくありません。

nginxのワーカー数・Keepalive調整

Nginxの性能を決める重要なパラメータに worker_processes と worker_connections があります。

worker_processes は通常 auto に設定し、CPUのコア数に合わせます。worker_connections は一つのワーカーが扱える同時接続数で、アクセス数が多いサイトではこの値を増やします。

また、keepalive_timeout を調整してTCP接続を維持する時間を制御することで、接続確立のオーバーヘッドを減らし、レスポンス速度を向上させることができます。

Java側(JVM)で行うべきパフォーマンス調整

Nginxだけでなく、受け手であるJava側のチューニングも不可欠です。

特にJVM(Java仮想マシン)のヒープメモリ設定は重要です。-Xms(初期メモリ)と -Xmx(最大メモリ)を適切に設定し、頻繁なガベージコレクション(GC)が発生しないようにします。

SpringBootを使用している場合は、内蔵Tomcatのスレッド数も調整ポイントです。同時リクエスト数に合わせて最大スレッド数を設定しましょう。

ログ設計(nginxログとJavaログの統合)

障害発生時に迅速な調査を行うためには、ログの連携が鍵となります。

Nginxのアクセスログには「リクエストID」を付与し、それをヘッダーとしてJava側に渡す設定を行います。Java側でもそのリクエストIDをログに出力するようにすれば、一つのリクエストがNginxに入ってからJavaで処理されるまでを一気通貫で追跡できるようになります。

これができていると、トラブルシューティングの時間が大幅に短縮されます。

javaとnginxの連携を採用するべきケース

最後に、どのような場面でこの連携構成を採用すべきかをまとめます。

結論としては、商用レベルのWebサービスであれば、ほぼ全てのケースで採用すべきです。

高負荷サイトでのスケール戦略

アクセス数が予測できない、あるいは急増する可能性があるサイトでは必須の構成です。

Nginxを挟んでおくことで、バックエンドのJavaサーバーを容易に追加・削除できるからです。キャンペーンなどでアクセスが集中した際も、Nginxが交通整理を行い、システム全体のダウンを防いでくれます。

APIゲートウェイ的にnginxを使う場合

マイクロサービスアーキテクチャのように、裏側に多数のサービスが存在する場合、Nginxが入り口(ゲートウェイ)として機能します。

認証処理やルーティング、レートリミット(アクセス制限)などをNginxで一元管理することで、各マイクロサービスの実装をシンプルに保つことができます。大規模システムになればなるほど、この恩恵は大きくなります。

クラウド環境(AWS/GCP)での構成例

AWSやGCPなどのクラウド環境でも、この構成は健在です。

クラウドロードバランサー(ELBなど)の下にNginxを配置し、その下でJavaを動かす構成がよく取られます。または、DockerコンテナとしてNginxとJavaをセットでデプロイする構成も一般的です。

どのようなインフラ環境であっても、NginxとJavaの連携は、堅牢で拡張性の高いシステムを作るための黄金の組み合わせなのです。

Javaアプリケーションの公開を考えているなら、ぜひNginxとの連携に挑戦してみてください。最初は設定に戸惑うかもしれませんが、一度構築してしまえば、その安定性と安心感は手放せなくなるはずです。

次のステップとして、まずは手元の開発環境にNginxをインストールし、ローカルのJavaアプリへリクエストを転送する簡単な設定から始めてみてはいかがでしょうか。